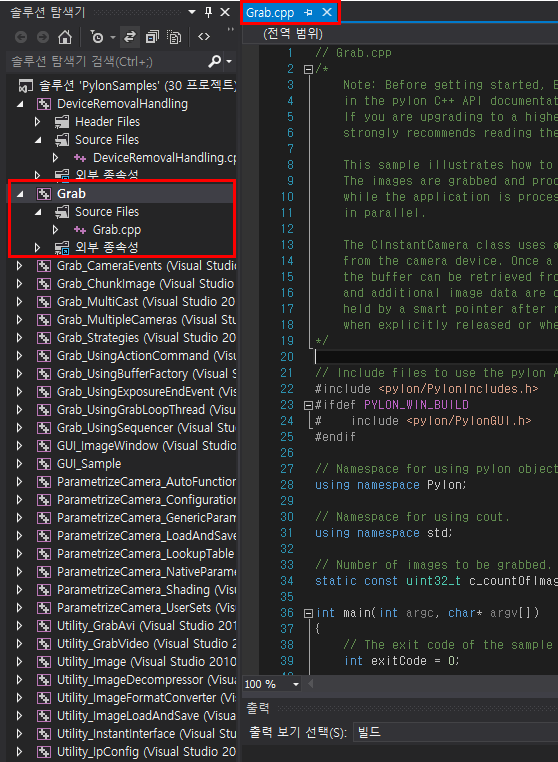

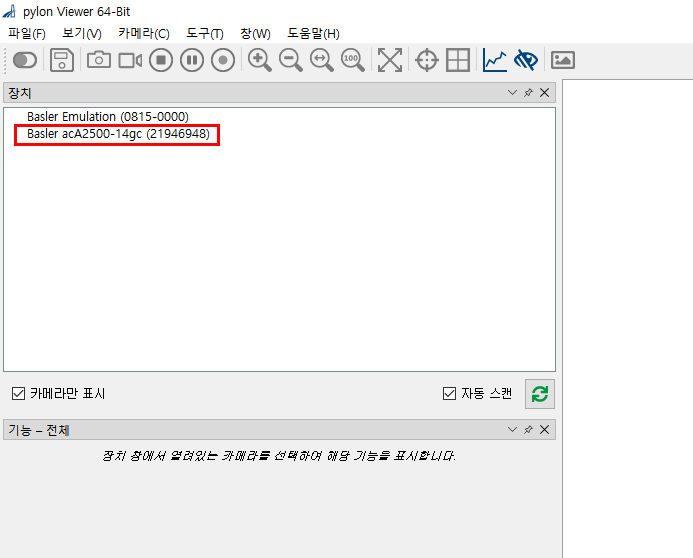

Basler Camera acA2500-14gc 카메라를 리눅스 환경에서 다뤄보려고 한다.

해당 카메라는 GigE(Giga Ethernet)통신을 사용한다.

랜선을 통한 통신방법인데 나는 우분투를 듀얼부팅이 아닌 가상환경(VirtualBox)에 설치를 해두었기에

GigE통신을 사용하여 카메라를 연결하는데 어려움이 있었다.

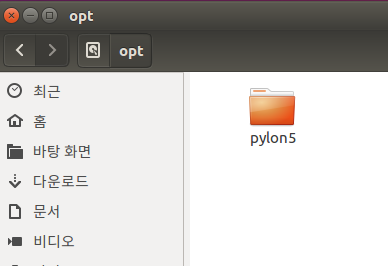

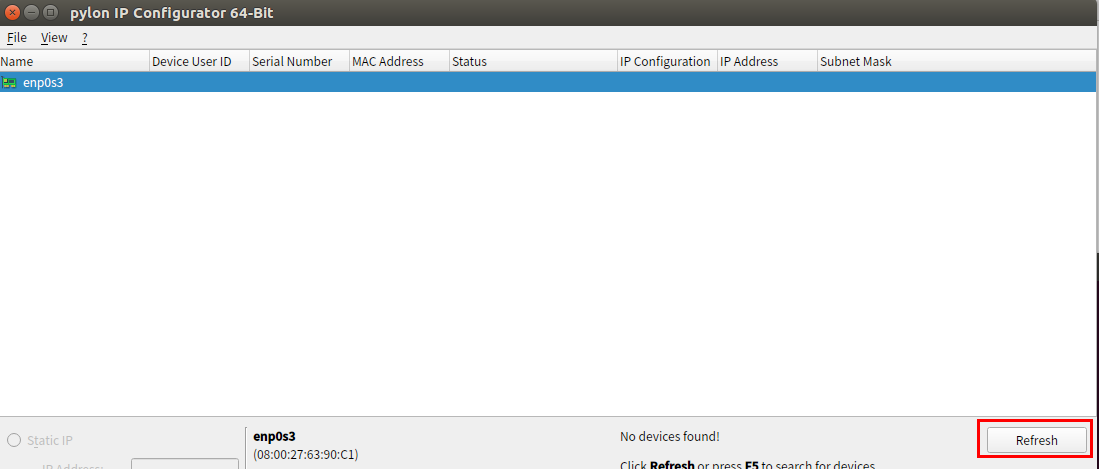

우선 리눅스 환경에서 pylon에서 제공하는 패키지를 풀게되면

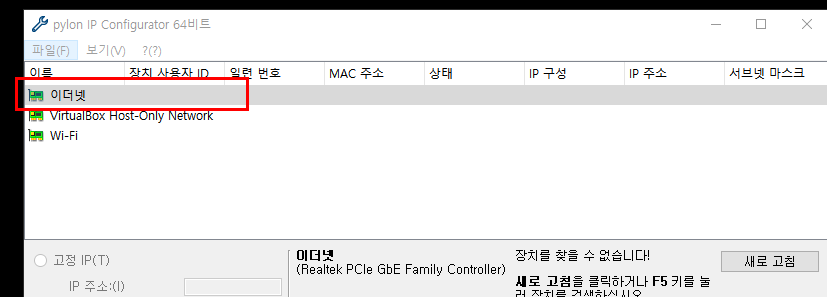

ipconfigrator 이라는 실행파일이 생기게 된다.

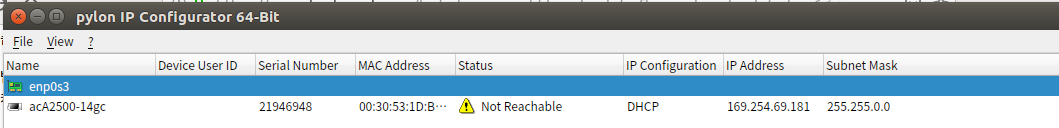

이를 실행시키면 위와 같은 창이 뜨게된다.

이 부분에 카메라의 정보가 떠야하는데 보다싶이 이더넷 정보만 있고 카메라에 대한 정보는

뜨지 않는걸 확인할 수 있다.(제대로 연결이 안됐기 때문)

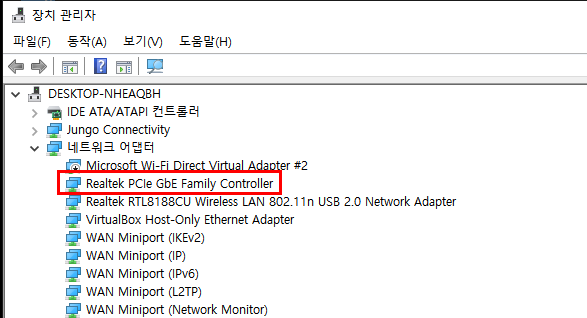

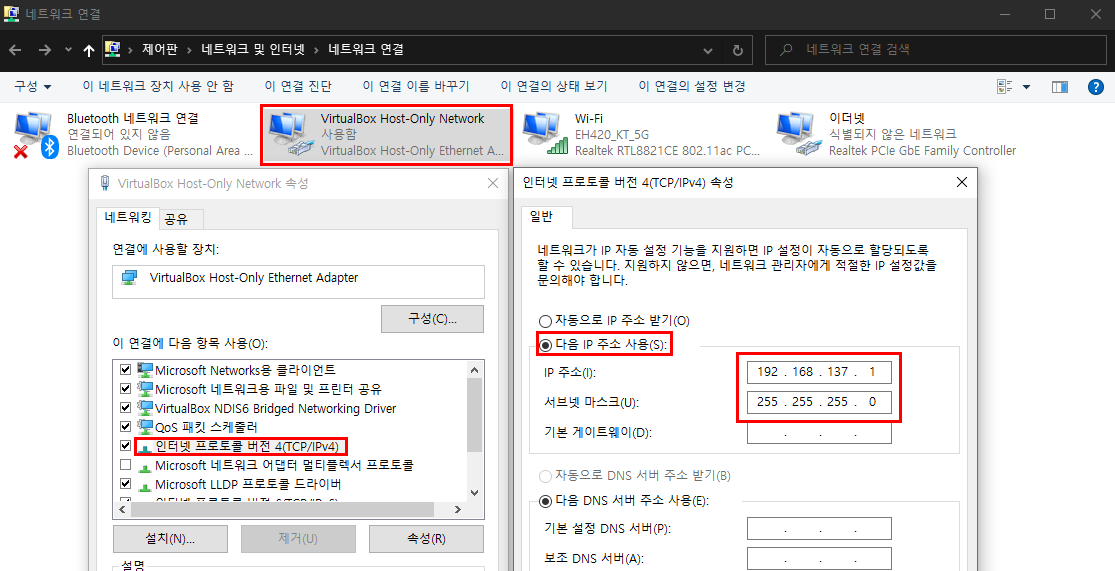

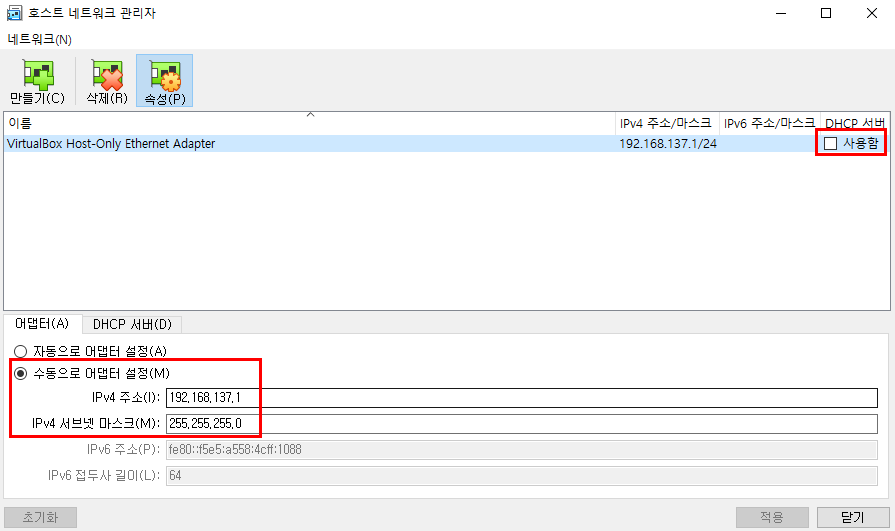

그럼 제어판의 네트워크 환경으로 들어가 다음과 같이 설정해주도록 한다.

"VirtualBox Host-Only Network"의 IP주소를 192.168.137.1 로 고정해주고 서브넷 마스크는 255.255.255.0 으로

고정시켜주었다.

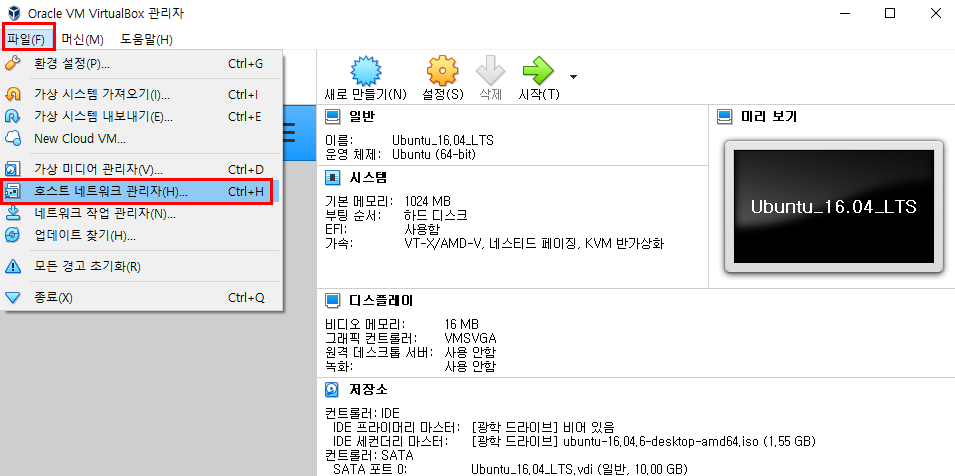

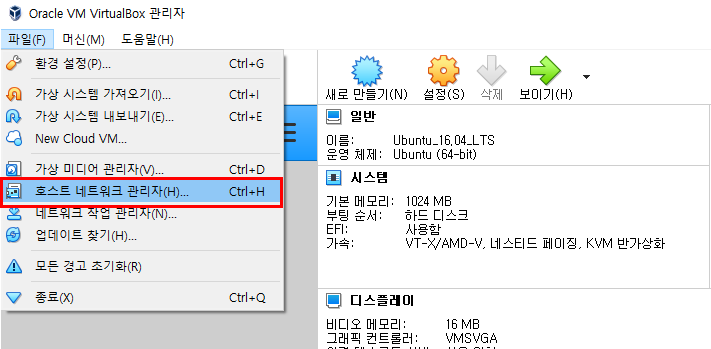

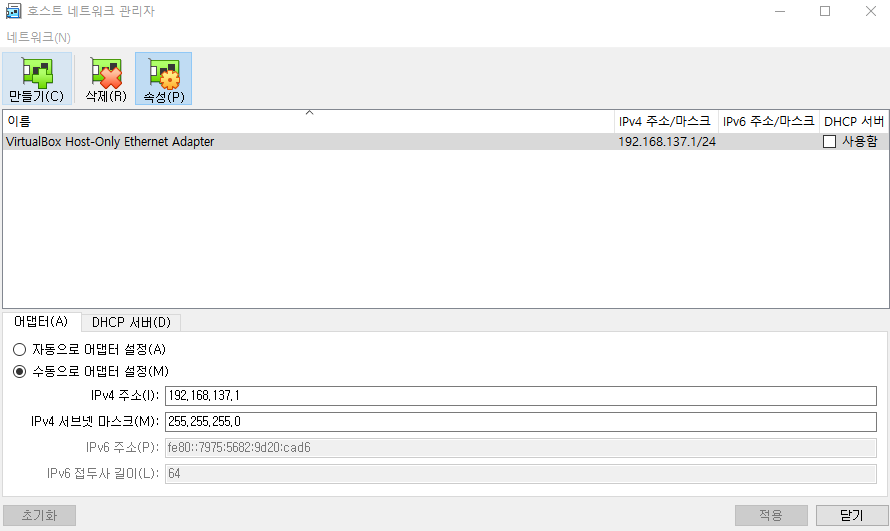

그럼 VirtualBox 프로그램 창의 좌측 상단의 "파일" 탭에서 "호스트 네트워크 관리자"를 클릭한다.

"수동으로 어뎁터 설정" 에서 IP주소와 서브넷 마스크를 Windows 네트워크 설정에서 지정해준 IP대로

맞게 되어있는지 확인하고 다르게 되어있다면 수정해준다.

이 때 우측 상단에 보이는 DHCP서버는 사용을 하지 않도록 체크박스를 해제해준다.

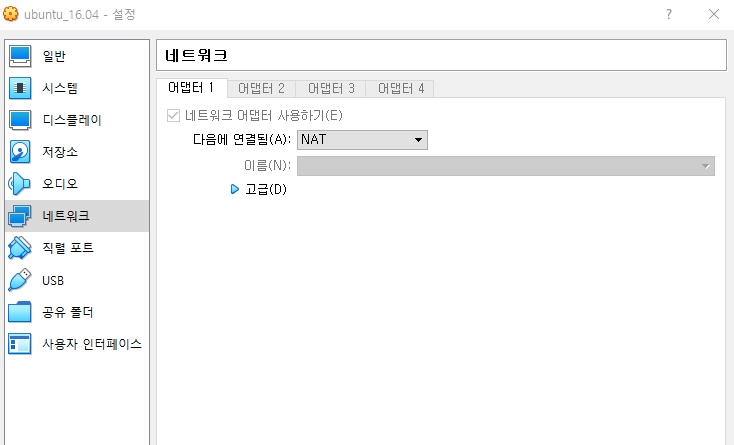

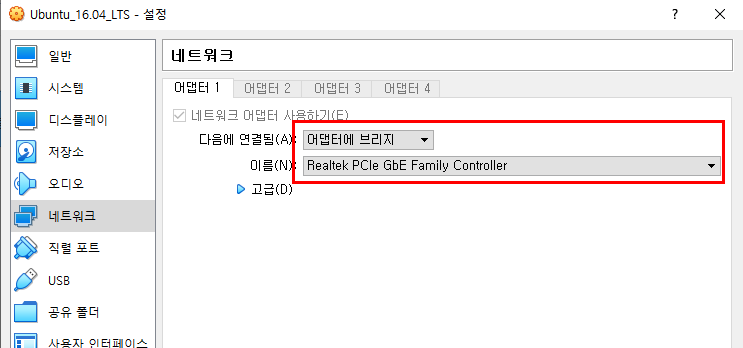

VirtualBox 프로그램창의 "설정" "네트워크"에서

"어뎁터에 브리지"로 다음과 같이 설정해 준 후 다시 Refresh를 눌러 새로고침을 하게 되면

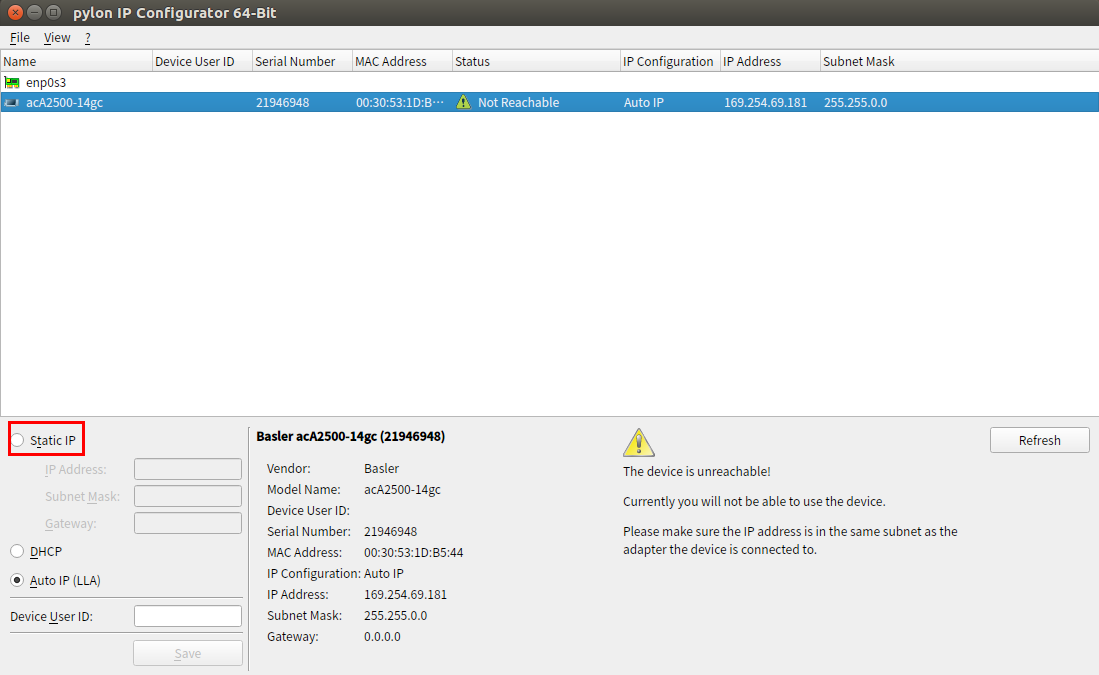

이렇게 Not Reachable 이라는 문구와 함께 카메라가 인식은 된 듯 하지만 연결은 잘 되지 않는 상태가 된다.

이는 아마 해당 이더켓 포트에 대해서 virtualbox와 Windows에서 사용하는 IP가 다르기에 발생하는 오류가 아닐까 예상된다.

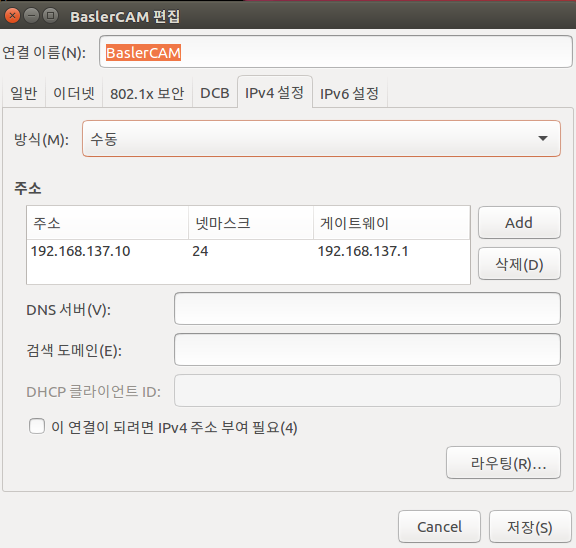

우분투의 네트워크 설정에서 아래와 같이 "옵션"에서 아래와 같이 설정

그 다음 우분투의 "설정"에서 "네트워크" 부분에 들어와 "옵션"을 선택한다

(이때 유선을 "켬"으로)

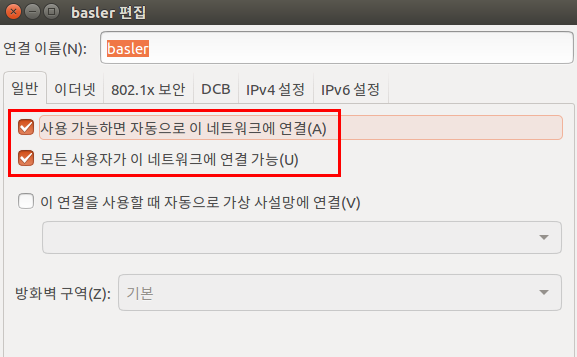

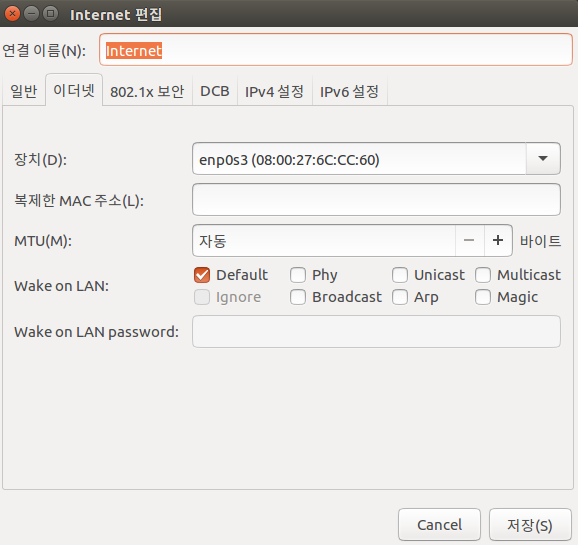

"일반" 탭에서는 위와 같이 설정한다.

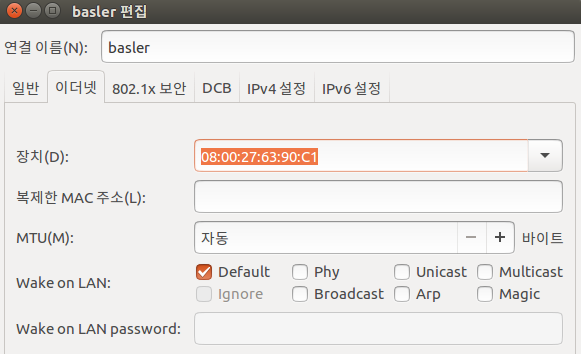

"이더넷" 탭에서는 위와 같이 설정한다.

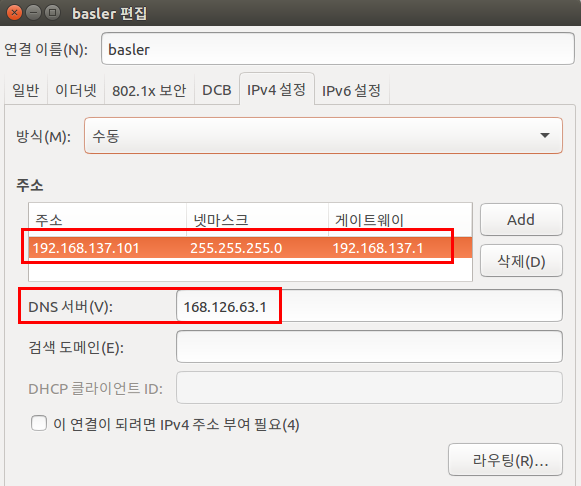

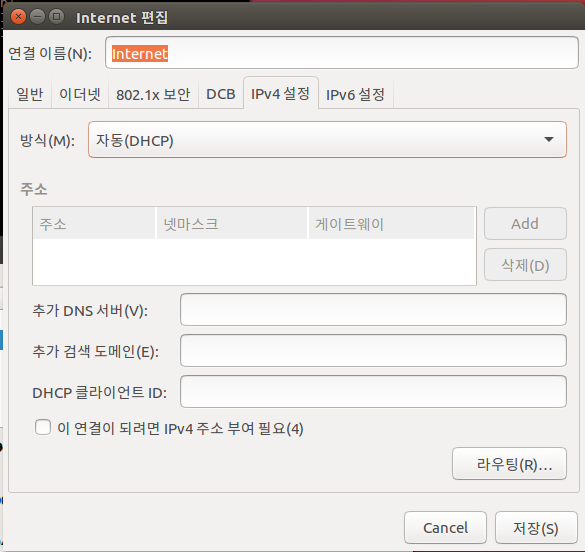

"IPv4 설정" 탭에서는 위와 같이 설정한다.

여기서 주소는 게이트웨이와 다름을 주의하자.

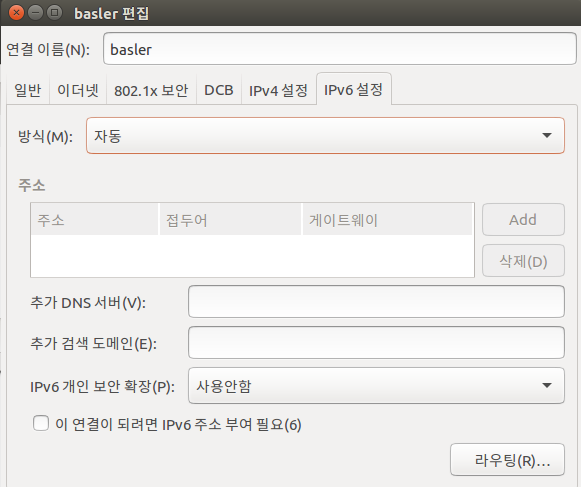

"IPv6 설정"탭은 위와 같이 설정한다.

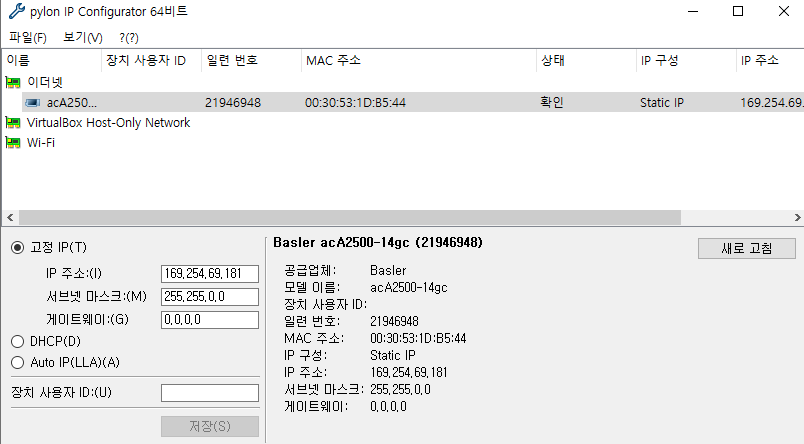

이제 다시 "IPConfigurator"을 실행시킨다.

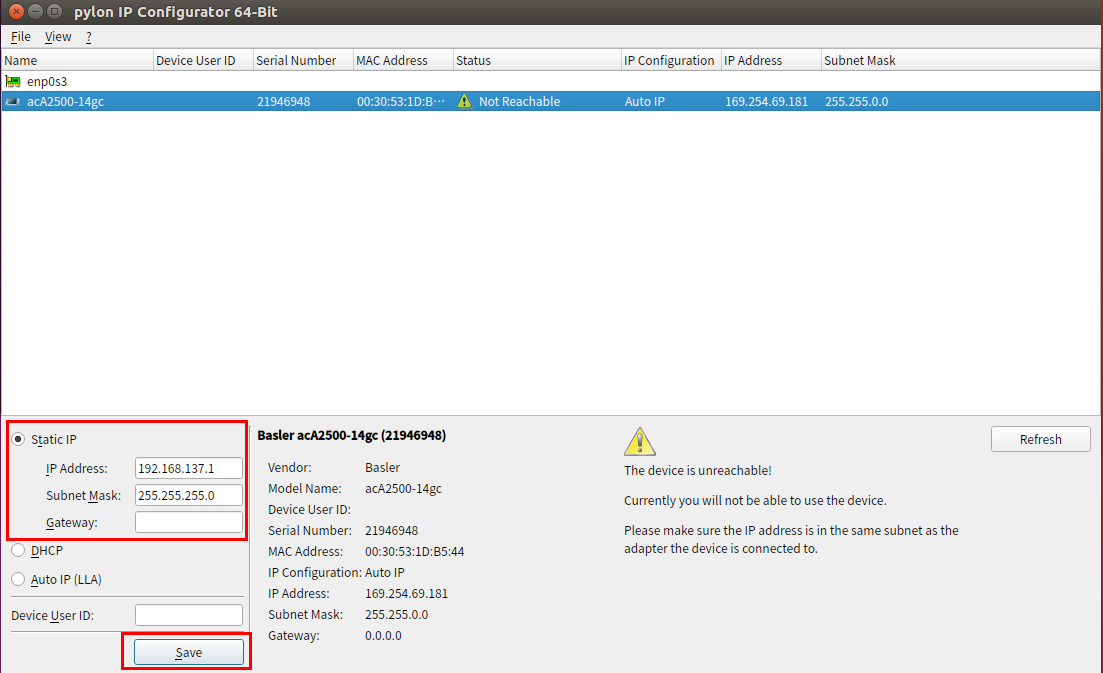

위와 같이 뜰 것인데 이때 좌측 하단의 "Static IP"를 선택한 후 아래와 같이 설정해준다.

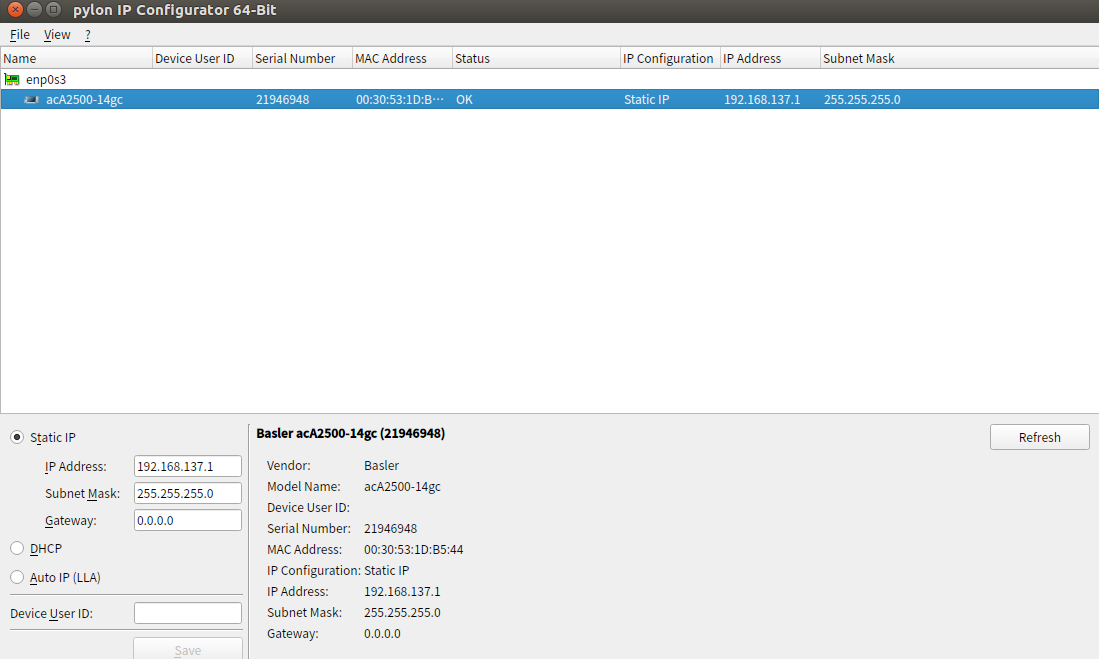

그리고 새로고침을 누르게 되면 정상적으로 연결이 된다.

https://dbrang.tistory.com/1279

[VM] VirtualBox 가상머신에 고정IP 설정하기 - ver.dBRang

/******************************************************************************************************************* -- Title : [VM] VirtualBox 가상머신에 고정IP 설정하기 - ver.dBRang -- Reference :..

dbrang.tistory.com

*******************************************************************************

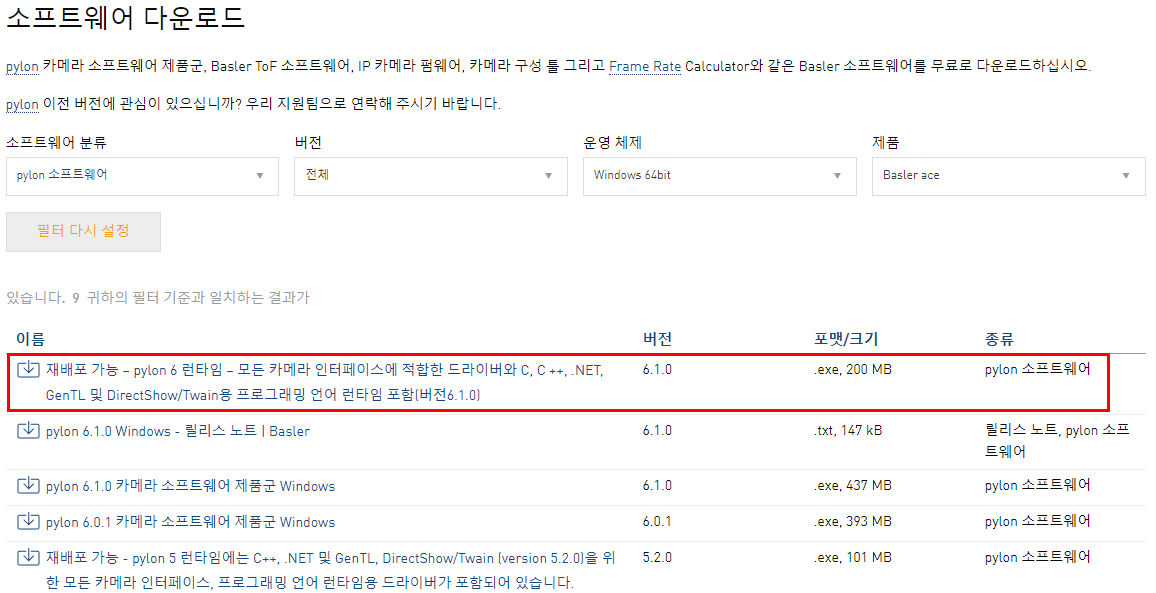

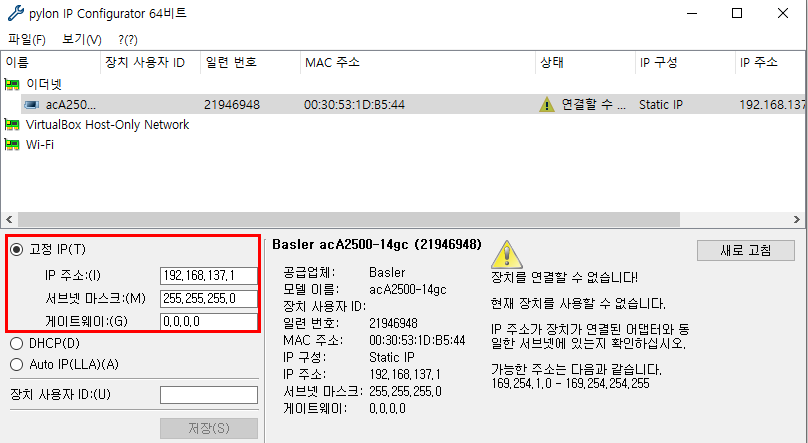

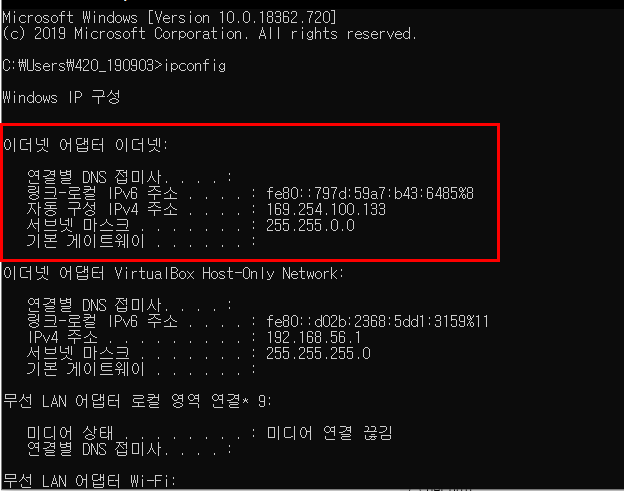

윈도우 환경에서도

연결이 잘 안될때는 좌측 하단의 고정IP를 활용한다.

ipconfig를 통해 이더넷 어뎁터의 IP주로솨 서브넷마스크를 입력해준다.

IP를 변경했더니 잘 연결되는 것을 확인할 수 있다.

------------------------------------------------------------------------------------------------------------------------------

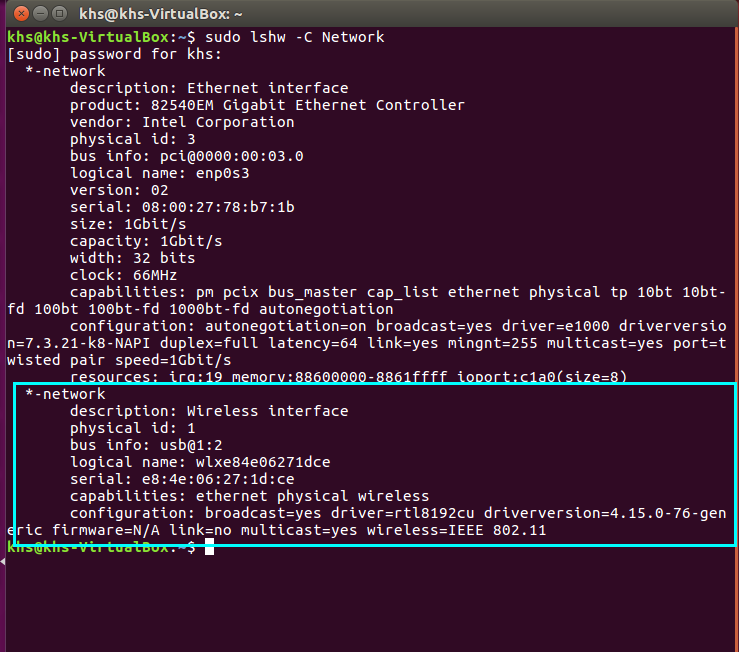

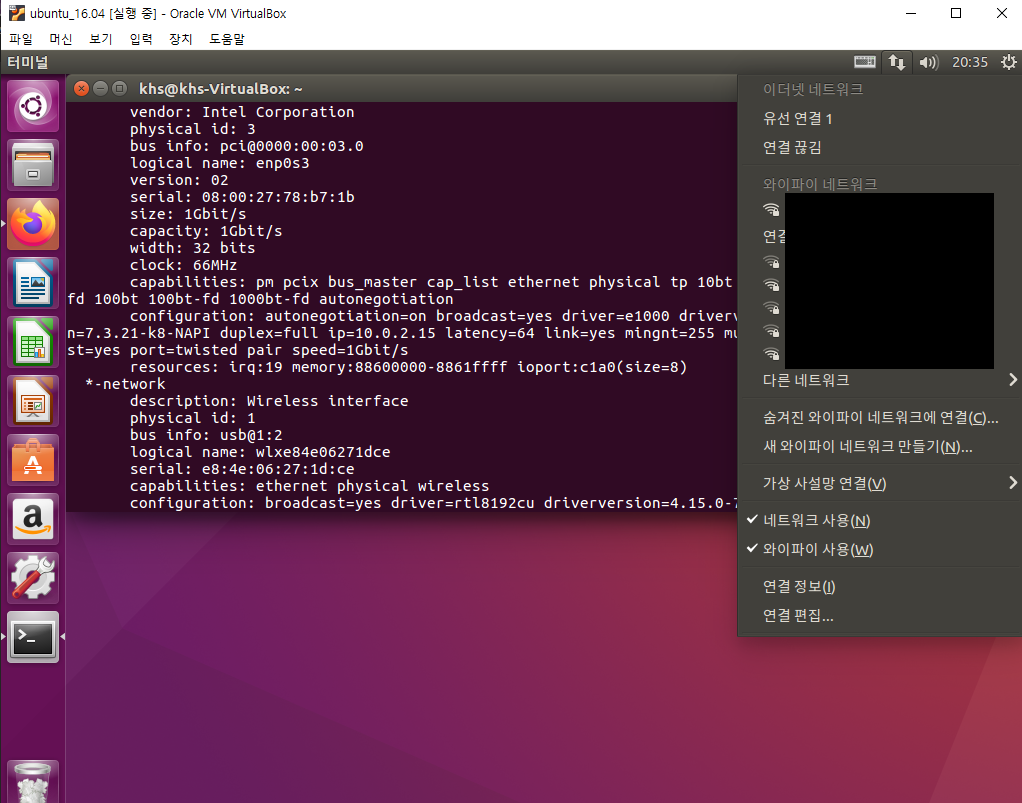

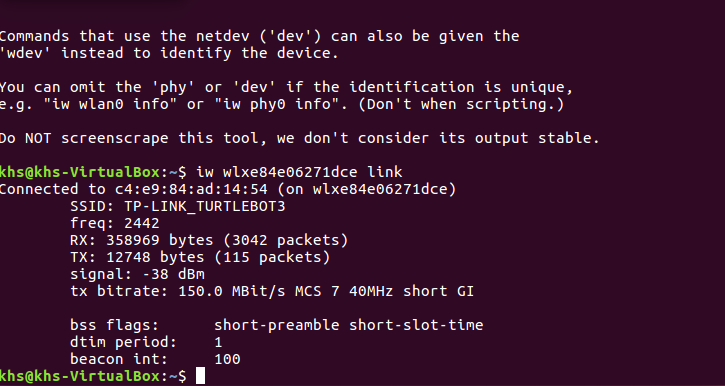

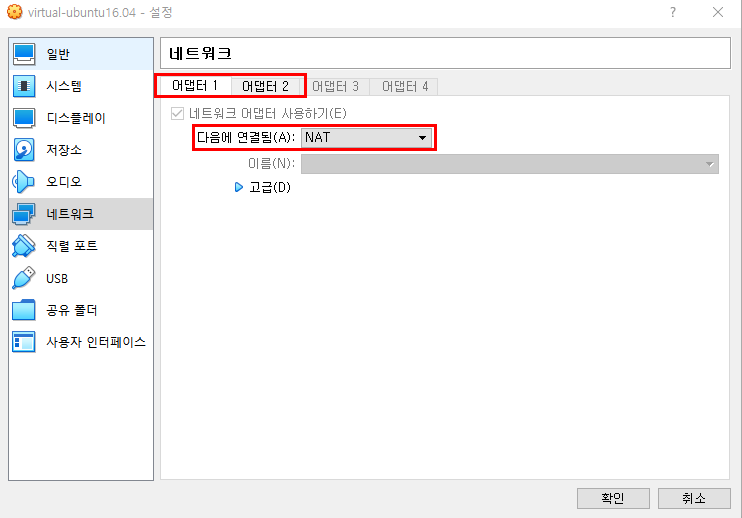

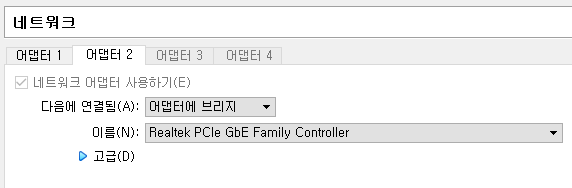

이 부분까지 되었으면 이제 와이파이까지 연결해보자.

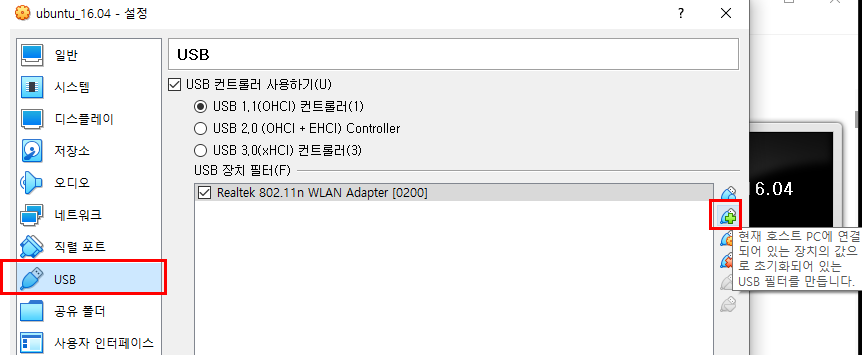

VirtualBox에서

네트워크 어뎁터를 2개를 사용하는데 첫번째로는 NAT에 연결하고

어댑터2는 아래와 같이 연결한다.

(이 때 호스트 네트워크는 이 전 상태와 같이 유지한다.)

그리고 우분투의 실행창에서

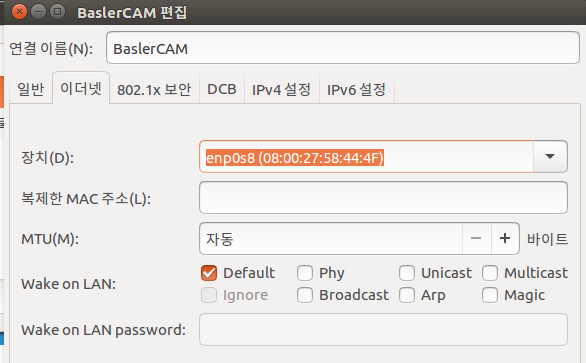

WIFI에 관한 네트워크를 위와 같이 IP가 자동으로 설정되도록 하고 이더넷 부분에서 해당되는 이더넷을 선택해준다.

GigE 연결에 관련된 네트워크는 위와 같이 수동으로 IP를 설정해주고 이더넷 부분에서 해당되는 이더넷을 선택해준다.

'Ubuntu' 카테고리의 다른 글

| Ubuntu 16.04 PCL1.8 Library 설치 (0) | 2020.10.06 |

|---|---|

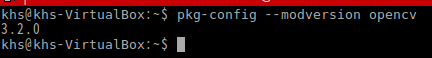

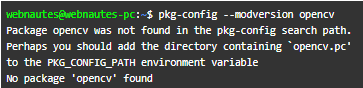

| Ubuntu 16.04 에 OpenCV 3.2 설치 (0) | 2020.10.06 |

| Linux(Ubuntu)에서 GigE카메라(Basler) 출력하기 (0) | 2020.04.06 |

| 윈도우에서 basler 카메라 출력 (0) | 2020.04.06 |

| ubuntu에서 opencv를 이용한 Lena출력 (0) | 2020.04.02 |